液冷 GPU 工作站

液冷 GPU 工作站为高性能计算提供强劲的GPU算力,服务于深度学习、科学计算、图形可视化、视频处理多种应用场景。蓝海大脑作为信誉良好的企业,随时提供触手可得的算力,有效缓解计算压力,提升业务效率,助力企业提升竞争力。

产品特点

- 搭建 NVIDIA4× L40S / A800 / A100 / H100 / H800 / 4090

- 使用 NVLink + NVSwitch的最高GPU通信

- 4个用于 GPU Direct RDMA的NIC(1:1 GPU比率)

- 最高4 x NVMe用于 GPU 系统盘,带有 AIOM

- 双电源冗余供电系统、防雷击、防浪涌保护

应用场景

-深度学习、数据挖掘、大数据分析

- 图像处理、仿真测试、BIM

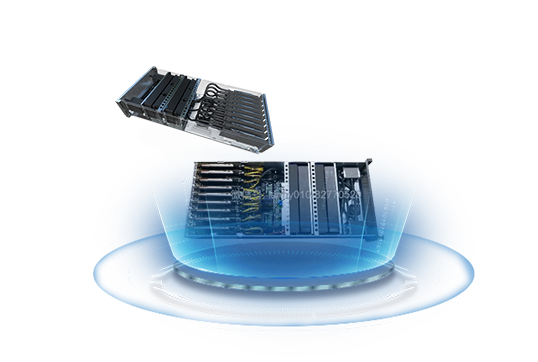

液冷 GPU 服务器

液冷 GPU 服务器为深度学习提供强劲的GPU 算力,服务于深度学习、云计算、科学计算、图形可视化、目标检测、仿真测试、BI等场景。

产品特点

- 搭建 NVIDIA4× L40S / A800 / A100 / H100 /H800 / 4090

- 使用 NVLink + NVSwitch 的最高GPU通信

- 4个用于 GPU Direct RDMA 的 NIC(1:1 GPU比率)

- 最高4 x NVMe 用于 GPU 系统盘,带有 AIOM

- 双电源冗余供电系统、防雷击、防浪涌保护

应用场景

-深度学习、数据挖掘、大数据分析

- 图像处理、仿真测试、BIM

液冷 GPU 服务器(9卡)

适用于人工智能、深度学习、HPC、数据挖掘、大数据分析、高性能计算等场景,搭载英伟达L40S / A800 / A100 / H100 /H800 / 409040GB或 80GB GPU卡,支持灵活I/O。

产品特点

- 使用NVLink+NVSwitch的最高GPU通信

- 8个用于GPUDirectRDMA的NIC(1:1GPU比率)

- 最高8 xNVMe 用于GPU直接存储(PLX默认4xNVMe)带有AIOM

- 支持的灵活I/O

设计特点

- 适用于 NVIDIA HGX A100 8-GPU 的高密度

- 4U系统使用 NVIDIA NVLINK + NVIDIA NVSwitch 的最高GPU通信

- 9个用于 GPU Direct RDMA 的NIC(1:1 GPU比率)

- 高达8倍的 NVMe用于 GPU 直接存储和具有 AIOM 支持的灵活I/O

应用场景

-人工智能、深度学习、 HPC、数据挖掘、大数据分析

如果您对此感兴趣,欢迎问问展商吧!

如果您对此感兴趣,欢迎问问展商吧!

暂无数据

暂无数据 暂无数据

暂无数据 如果您对此感兴趣,欢迎问问展商吧!

如果您对此感兴趣,欢迎问问展商吧!